AI & UX: van strategie tot uitvoering

Een drieluik over het succesvol implementeren van kunstmatige intelligentie in gebruikerservaringen.

Deze drie artikelen vormen een gids voor het ontwerpen van AI-ervaringen die daadwerkelijk waarde toevoegen. Van strategische scoping tot praktische implementatie en kritische evaluatie; elk artikel bouwt voort op het vorige en biedt concrete handvatten voor organisaties die AI willen inzetten zonder in bekende valkuilen te trappen.

Wil je begrijpen hoe jouw organisatie AI effectief kan inzetten? Onze AI Scan laat zien waar de belangrijkste kansen liggen en waar nog werk te doen is.

AI Experience Audit: wat werkt wel en wat niet?

De implementatie van artificial intelligence bevindt zich in een overgangsfase tussen innovatie en ‘maturity’. Dit leidt tot nogal wat chaos, waarbij organisaties experimenteren en de grenzen van de UX verkennen. Daarom is een grondige audit van zowel succesvolle als frustrerende AI-ervaringen noodzakelijk om te bepalen wanneer AI daadwerkelijk waarde toevoegt aan de gebruikerservaring. Laten we beginnen met het benoemen van AI-interfaces die niet lekker werken.

Wat mislukte AI-ervaringen ons leren

Mislukte AI-implementaties delen vaak het probleem; van te hoge verwachtingen tot aan gebrekkige transparantie.

1. Rufus: Amazon’s AI-bot Rufus zorgde voor een hoop verwarring bij gebruikers. Terwijl zij gebruik maakten van de zoekbalk, werden er tussendoor AI-suggesties onder de standaard auto-aanvulling weergegeven. Daarnaast plaatste Amazon de bot op een prominente maar ongebruikelijke plek in de topnavigatie. Uit onderzoek bleek dat niemand deze knop opmerkte tijdens het winkelen. Dit toont aan dat wanneer een AI-functie wordt gepositioneerd vanuit businesskeuzes in plaats van gebruiksvriendelijkheid, de functie uiteindelijk volledig onvindbaar kan worden.

2. Te weinig begeleiding: omdat veel AI-producten te breed zijn opgezet, weten gebruikers vaak niet hoe ze moeten starten, wat de drempel om een vraag te stellen verhoogt. Wanneer gebruikers bijvoorbeeld de vraag "Hoe kan Claude vandaag helpen?" zien, is er geen duidelijke begeleiding. Als het systeem dan faalt, weten gebruikers niet of ze het verkeerd gebruiken of dat het een beperking van de technologie is, wat leidt tot frustratie en verlies van vertrouwen.

3. Opt-Out hinder: het gebrek aan keuzevrijheid bij gebruik van een AI-tool is een veelvoorkomende fout. Slack implementeerde een AI-functie op basis van ‘quiet opt-in’, waarbij gebruikers een e-mail naar de supportafdeling moeten sturen om zich af te melden. Het niet bieden van eenvoudige opt-in/opt-out controles schaadt het vertrouwen en is een slecht UX-voorbeeld.

Voorbeelden van goede AI-integratie

Naadloze integratie wordt meestal bereikt zodra de AI-tool een duidelijk probleem oplost.

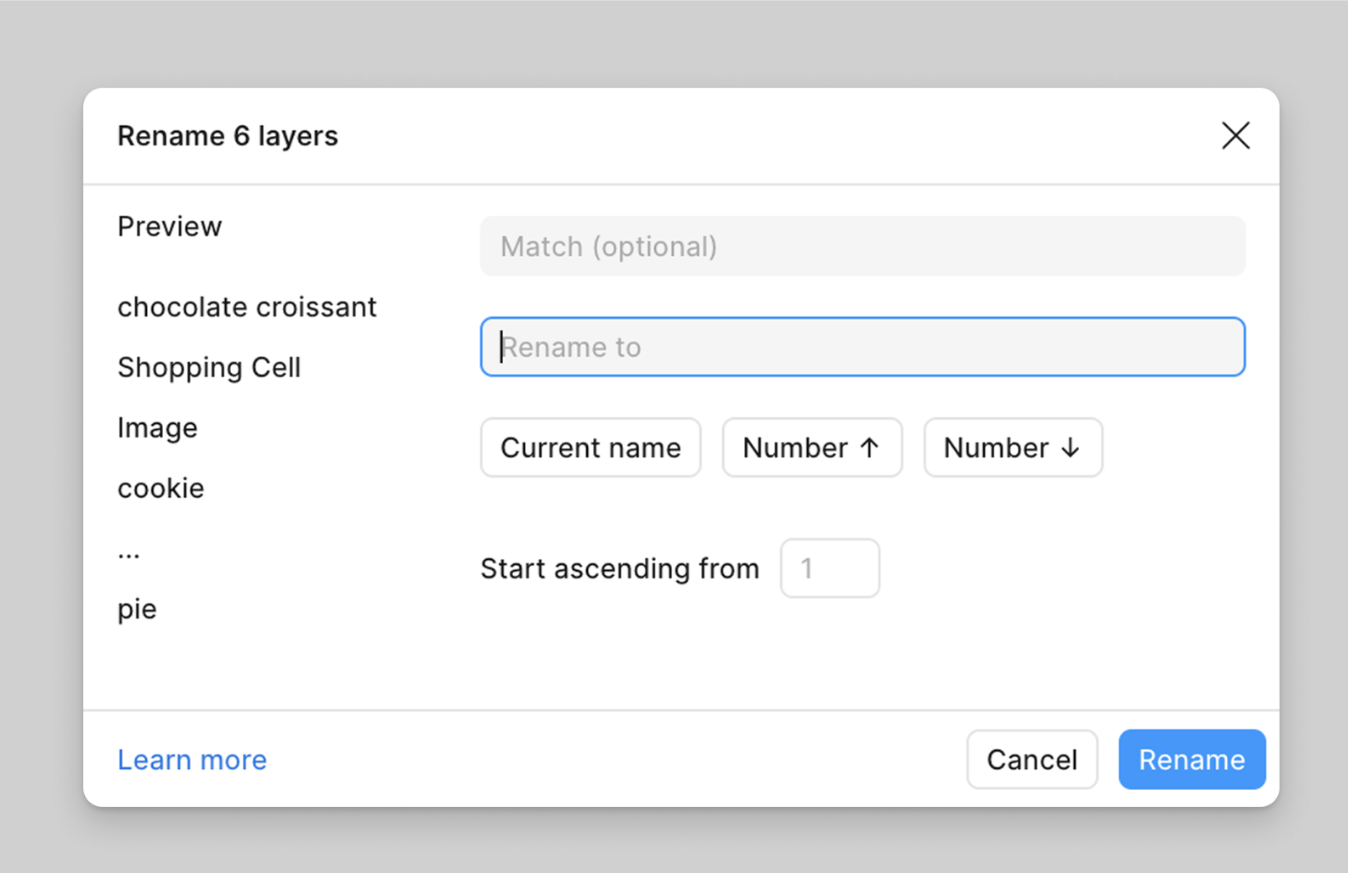

1. 'Rename Layers': dit is een uitstekend voorbeeld van een goed geïmplementeerde AI-functie. Het startpunt is een vervelend probleem dat ontwerpers dagelijks ervaren: het hernoemen van layers. De oplossing is duidelijk, de functie is goed afgebakend en biedt directe waarde.

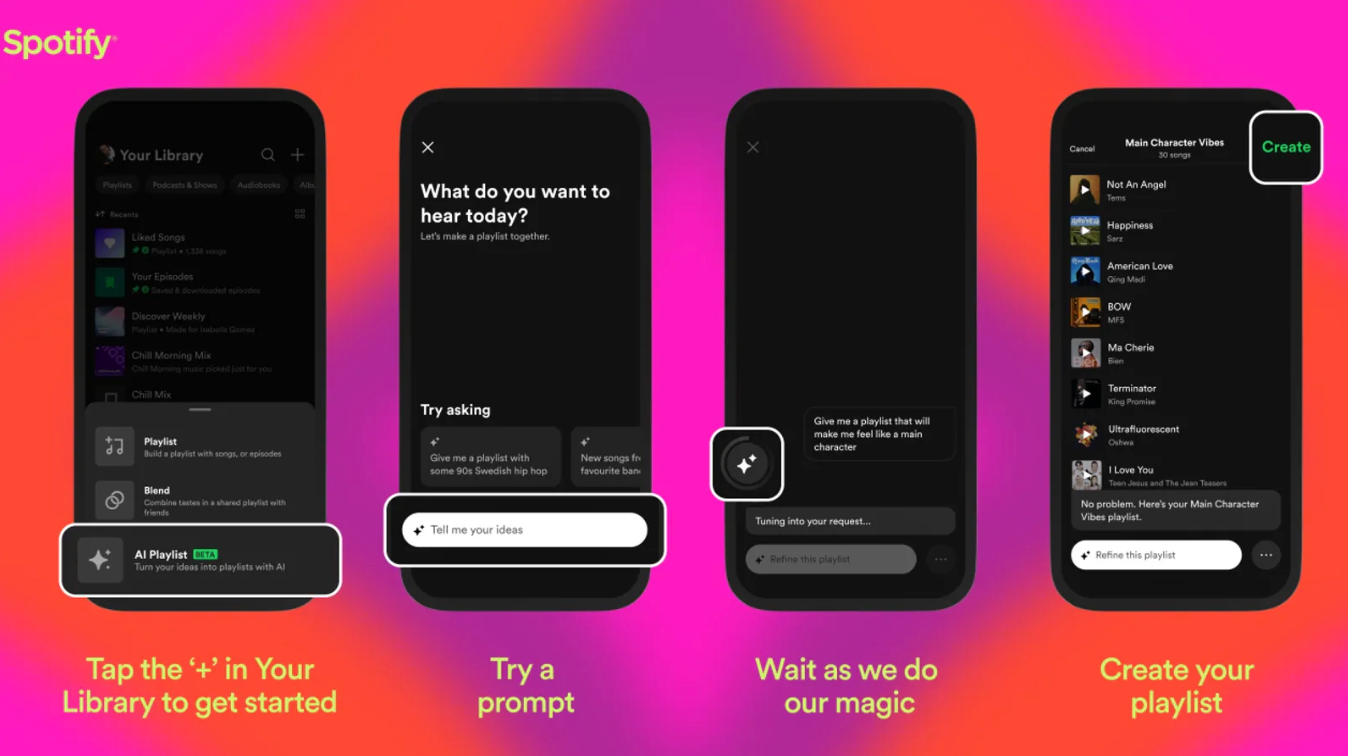

2. AI Playlists: Spotify's AI-afspeellijsten geven snel resultaat en bieden gebruikers de mogelijkheid om expliciete feedback te geven (zoals aangeven dat een nummer niet opnieuw moet worden aanbevolen). Hierdoor voelen gebruikers zich in controle over de AI-suggesties; dit is cruciaal voor het opbouwen van vertrouwen.

3. Transparantie door Bronvermelding: Elicit en NotebookLM laten zien waar hun informatie vandaan komt; transparantie door bronvermelding. Daardoor voelt een gebruiker zich zekerder over de output. Daarnaast helpen deze tools om de gebruiker structuur en richting te geven, wat de interactie met de AI-tool bevordert. En dankzij de bronvermelding kan de gebruiker controleren of de gegeven informatie klopt.

4. Proces zichtbaarheid: Perplexity communiceert, terwijl er een antwoord wordt geformuleerd, door 'thinking' of 'reasoning' te tonen via inference indicators. Deze signalen laten gebruikers zien dat het systeem actief informatie aan het verzamelen, analyseren of afwegen is. Het licht bijvoorbeeld toe dat het aanvullende bronnen raadpleegt, meerdere stappen moet doorlopen of extra tijd nodig heeft om een complexere vraag zorgvuldig te verwerken. Daardoor weten gebruikers niet alleen dat het systeem bezig is, maar ook waarom, wat bijdraagt aan een gevoel van transparantie en controle.

Hoe meet je succes van AI-functionaliteiten?

In artikel 1 bespraken we hoe je AI goed kunt scopen en in artikel 2 gingen we in op de best practices voor het ontwerpen van een AI-functionaliteit. Maar hoe meet je vervolgens of die functionaliteit haar doelen daadwerkelijk bereikt?

1. Het meten van gebruikersvertrouwen: vertrouwen is een cruciale maar moeilijk te meten factor. Daarbij speelt het mentale model van de gebruiker een grote rol. Dit model verwijst naar het beeld dat iemand heeft van hoe een systeem werkt, wat het kan en wat het niet kan. Dus het mentale model bepaalt hoeveel vertrouwen een gebruiker heeft in de output.

Gebruikersvertrouwen kan onder andere worden bereikt door:

- Kwalitatief onderzoek: door middel van user interviews, observaties en competitive research krijg je inzicht in hoe gebruikers denken, welke aannames ze hebben over AI en waar hun twijfels zitten. Dit helpt om verwachtingen en mentale modellen al in een vroege fase scherp te krijgen.

- Wizard of Oz-techniek: hierbij laat je gebruikers een prototype ervaren dat lijkt te worden aangestuurd door AI, terwijl een mens achter de schermen de antwoorden levert. Dit maakt het mogelijk om snel te testen hoe gebruikers reageren op conceptuele AI-functionaliteiten en hoeveel vertrouwen zij hebben in de output, zonder dat er al een technisch werkend model is.

- Confidence-weergave: het zichtbaar maken van confidence-scores of zogenaamde ‘onzekerheidsindicatoren’ creëert transparante interfaces. Door zichtbaar te maken hoe zeker een model is van zijn antwoord, kunnen gebruikers beter inschatten wanneer ze de output moeten controleren of aanvullen, wat het vertrouwen in het systeem versterkt.

2. Prestaties en fail metrics: om te zien hoe goed AI werkt voor gebruikers, kijken we verder dan standaard statistieken zoals hoeveel mensen het product gebruiken of terugkomen. Belangrijk is om te meten hoe vaak AI fouten maakt en hoe betrouwbaar de output is:

- Hallucination rate: hoe vaak geeft de AI verkeerde of verzonnen antwoorden? Het gaat hierbij om foute of verzonnen feiten, bijvoorbeeld een fictieve naam of locatie die de AI erbij haalt.

- Accuracy, ofwel juistheid, van de output: zorgen dat de AI correcte en bruikbare informatie geeft. Het gaat hierbij om interpretatiefouten, incomplete antwoorden of verkeerde inschattingen, waardoor de output bijvoorbeeld niet relevant is.

- Gebruikerservaring (UX): meten hoe gebruikers de AI ervaren, bijvoorbeeld door te kijken of ze begrijpen wat de AI doet, of ze duidelijke feedback krijgen, en of ze het proces makkelijk kunnen volgen.

Van strategie tot uitvoering

De vraag is niet meer óf je AI inzet in je product, maar hoe je dat op een verantwoorde manier doet. Hopelijk bieden de cases in dit artikel een checklist: Is het probleem duidelijk? Kan de gebruiker de output verifiëren? Is er ruimte voor feedback en controle?

Ben je het overzicht kwijt? Volg dan de deze stappen:

- Audit je huidige AI-implementaties aan de hand van de succesvoorbeelden.

- Test met echte gebruikers voordat je uitrolt (denk aan de Wizard of Oz-techniek).

- Meet niet alleen gebruik, maar vooral vertrouwen en fail rates.

Artificial intelligence in UX is een iteratief proces. Start met experimenteren, leer van wat niet werkt, en bouw stap voor stap aan ervaringen die gebruikers daadwerkelijk helpen.